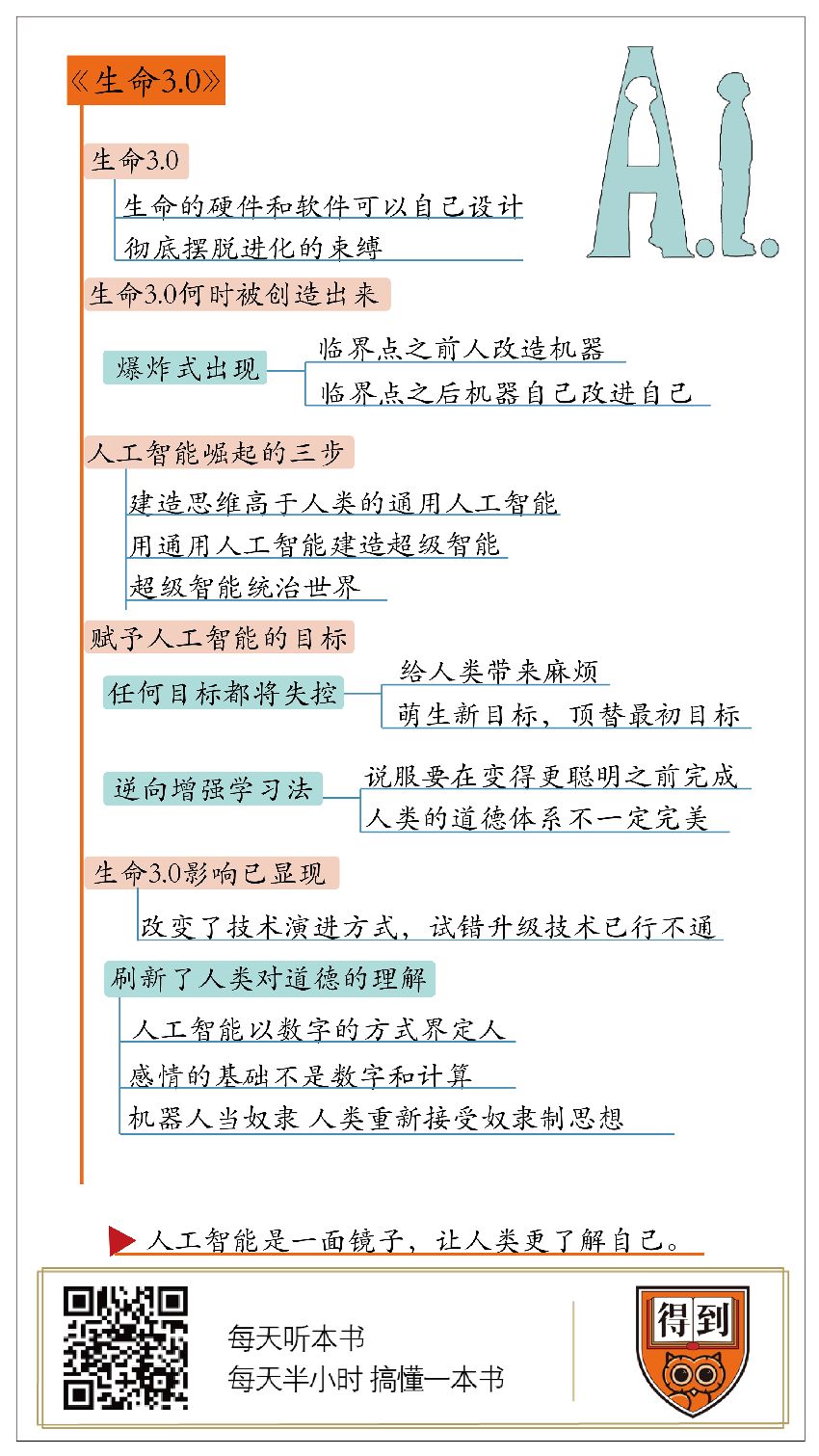

生命3.0

關於作者

邁克斯·泰格馬克,麻省理工學院物理系終身教授,《科學》雜誌「2003年度突破獎」第一名獲得者,被譽為「最接近理查德·費曼的科學家」,著有暢銷書《穿越平行宇宙》。

關於本書

關於人工智慧的爭論從未停止,支持者和反對者都有各自的理由,不管你的態度是悲觀、樂觀還是中立,至少我們都該弄清楚一個基礎問題——人工智慧和以往的工具、和人類自身的區別到底是什麼?為此,邁克斯·泰格馬克創辦了未來生命研究所,投入大量精力研究人工智慧,並拜訪了很多人工智慧領域有實際經驗的前沿人物,比如埃隆·馬斯克、拉里·佩奇等,彙集眾人的思想精華,同時又融入自己的思考,寫成了這本《生命3.0》。

核心內容

人工智慧到來的方式,不是循序漸進的積累,而是爆炸式的突現。而且人工智慧的目標很難控制,這對人類來說有風險,所以,我們應該嘗試為它們裝載人類的道德倫理,來避免人工智慧造成危害。同時,人工智慧不僅帶來了技術上的改變,它也像一面鏡子,引發了一系列的倫理道德反思。

你好,歡迎每天聽本書。今天為你解讀的書是《生命3.0》,它的作者是曾經寫過《穿越平行宇宙》的美國作家,邁克斯·泰格馬克。這本書還有一個副標題,叫「人工智慧時代,人類的進化與重生」。

最近幾年關於人工智慧的著作有很多,比如《機器之心》,講的是假如機器人擁有人類的心靈會發生什麼。《機器之心》的作者相信,到2045年,人類就可以把意識上傳到大腦,實現間接的永生。還有一本書叫《超級智能》,講的是假如未來出現了超級人工智慧,會產生哪些機會和威脅。還有一本書叫《玻璃籠子》,說的是智能設備會使人類產生嚴重依賴,弱化人類自身的能力。這些書各有各的道理,但放在一起,態度差別特別大,我們也不知道該聽誰的。相比之下,這本《生命3.0》就相對中立。作者在寫書之前,投入了大量精力研究人工智慧,還創辦了一個研究所,他還專門拜訪了很多人工智慧領域有實際經驗的前沿人物,比如埃隆·馬斯克、拉里·佩奇等。換句話說,這本書不是作者一家之言,而是彙集了很多專家的思想精華。

這些思考主要來自四個派別。第一個是數字烏托邦主義者,代表人物是拉里·佩奇,他們認為數字生命是宇宙進化的必然結果,應該讓它們自由發展,只要人類不強加干涉,結果一定是好的。第二派是技術懷疑論者,他們覺得超級人工智慧幾百年內根本不可能實現,沒必要現在就杞人憂天。第三派名字有點長,叫人工智慧有益運動支持者,這是目前最主流的一派,他們認為,人工智慧總體上是有益的,但是必須以安全為前提,扎紮實實,不能冒進。第四派是盧德主義者。盧德是第一次工業革命時期的一個工人,他覺得機器的普及會讓他失業,就帶頭破壞了紡織機,後代人就用他的名字來指代那些憎恨機器、厭惡科技進步的人。在盧德主義者看來,人工智慧的前景就跟災難片一樣,一定會帶來毀滅性的結果,堅決反對。

在這本書里,泰格馬克把四個派別的思考做了系統化的加工,同時又融入了自己的研究成果,提出了「生命3.0」這個新概念。什麼叫生命3.0呢?首先,作者把生命的組成分為軟體和硬體,一切實體的,像器官、肢體、毛髮之類,都屬於硬體;一切意識、智力、感覺之類的非實體,都屬於軟體。

生命1.0,指的是硬體和軟體都靠進化獲得,且只能靠進化來獲得的生命體。除了人類之外,其他生物基本都屬於生命1.0。

生命2.0,指的是硬體靠進化,而軟體是可以自己設計的生命體。比如人類,我們的身體是進化來的,但是軟體可以自己設計,比如通過學習獲取知識、用社交來增進情感、靠訓練來增強意志等等。

生命3.0,指的是硬體和軟體都可以自己設計,也就是在人類所有能力的基礎上再增加一個,隨意改造設計自己身體的能力。換句話說,生命3.0完全是自己命運的主人,徹底脫離了進化的束縛。像電影《黑客帝國》里的母體、《終結者》里的天網、《變形金剛》里的汽車人和霸天虎、《復仇者聯盟》里的奧創,都屬於生命3.0。

那麼,生命3.0會在什麼時間被創造出來?該賦予它們什麼樣的目標?會對人類社會產生哪些影響?接下來,帶著這些問題,我將從三方面為你解讀這本《生命3.0》,你也可以把它們當成三組有關人工智慧的思想實驗。

第一部分

第一部分,生命3.0會在哪一年被創造出來?對此,行業一直有很多猜測,讀完這本《生命3.0》之後你會發現,這個問題本身就打偏了。我們最應該知道的,不是生命3.0哪年會出現,而是它會以什麼樣的姿勢出現。這個姿勢,不是緩緩走來,而是破門而入。

怎麼理解呢?咱們先說一件前幾年發生在人工智慧領域的大事。2016年3月,人工智慧程序 AlphaGo,戰勝了圍棋世界冠軍李世石。當時排名世界第一的棋手柯潔研究了棋譜以後說:雖然李世石輸了,但是我還能贏回來。過了一年多,柯潔和 AlphaGo 下棋,也輸了。柯潔開始時候的反應代表了人類的一種普遍反應:這次輸了不要緊,我有針對性地研究一番,還有機會。這其實反映了我們心裡的一個競賽模型,我們一直認為,人類和人工智慧之間的競賽就像是賽跑,今天你領先,明天我努努力,加快腳步,沒準兒就能超過你;大家在一個跑道上,這輪輸了不要緊,我們可以再比一輪。但事實上,這個比喻是不恰當的。人類和人工智慧之間的競賽不像跑步,更像是 Windows 系統里的那個掃雷小遊戲,只要觸發了爆炸,遊戲就結束了。

早在1965年,英國數學家歐文·古德就提出了「智能爆炸理論」。他大概的意思是,假如存在一台超級智能機器,那麼它的成長就不是循序漸進的,而是爆炸式的。只要它具備一個能力,可以設計出比自己更好的機器,那麼就會出現智能爆炸,人類的智力就會被遠遠甩在後面。換句話說,人工智慧的發展存在一個臨界點,這就是機器開始具備自我進化的能力。在這個臨界點之前,必須由人來改進機器,在這個臨界點之後,機器就可以自己改進自己,它的每一步都會創造下一步,這個過程就沒有人類什麼事了。只要這個技術節點被引爆,那麼人工智慧就完成了一次升維,成為和人類不同維度的、更高級的智能體,它之後和人類所有的競賽都是降維打擊,人類永遠都不再有翻盤的機會。這個假設有很多類似的理論支持,比如關於宇宙起源的暴脹理論,這是大爆炸理論的一種新版本,它認為,宇宙發展到今天,曾經經歷過翻倍式的增長,而且每次翻倍后,還會引發下一次翻倍。再比如著名人工智慧專家庫茲韋爾提出的加速回報定律,他認為,每隔一段時間,技術的能力就會翻倍。就像過去60年裡,每隔幾年,硬碟的存儲能力就會翻一倍,和60年前比起來,今天的硬碟價格已經便宜了1億倍。

那麼,發生一次智能爆炸需要多長時間呢?這取決於人工智慧需要的是新軟體還是新硬體。假如需要的是新硬體,可能要花幾個月或幾年、幾十年;假如只需要軟體,爆炸可能在幾小時、幾分鐘甚至幾秒鐘內就完成了。換句話說,超級人工智慧誕生的時刻,可能遠在天邊,也可能近在眼前。在這本書的開篇,作者虛構了一個故事,可以算作是關於人工智慧的一個思想實驗,具體是下面這樣的。

一個科學團隊在實驗室里開發出了一套名叫普羅米修斯的人工智慧,這可不是 AlphaGo 那樣的專用人工智慧,而是一套通用人工智慧,凡是人類具備的智力,它都具備,而且計算速度還要快得多。經過學習,不到一天,普羅米修斯就完成十次自我升級,掌握了人類世界的所有知識。科學家就開始用普羅米修斯計算股票,賺了很多錢。接下來的幾年裡,普羅米修斯自己又設計出了各種各樣的機器人,進入製造、運輸、零售、建築等等行業,取代了人類的勞動力。同時,普羅米修斯還學會了寫劇本、拍電影,而且它的電影不需要任何演員,一切都可以用電腦合成。普羅米修斯還通過傳媒來影響大眾,間接控制了各個國家的政治。沒過幾年,普羅米修斯就掌控了地球上所有的權力。

當然,這個故事是虛構的,但是根據智能爆炸理論,我們發現,人工智慧崛起,其實只需要三步。第一步,建造人類智力水平相當、但是思維速度要高於人類的通用人工智慧,也就是普羅米修斯。第二步,用這個通用人工智慧來建造更高級的、可以應用在各個領域的超級智能。第三步,使用或者放任這些超級智能來統治世界。

以上就是第一部分的內容,回顧一下。生命3.0的出現不是循序漸進的積累,而是爆炸式的突現,一旦這個爆炸發生,人工智慧具備了自我迭代升級的能力,它就會迅速進化,把人類遠遠甩在後面。

第二部分

這就引出一個非常關鍵的問題,如果超級智能出現以後,人類不可能再戰勝它,那麼就必須在它出現之前,也就是在設計階段,就想好如何馴化它。更具體一點,我們應該賦予它什麼樣的指令和目標,才能讓它成為人類的好幫手,而不是敵人?接下來,咱們進入第二部分,應該賦予人工智慧什麼樣的目標?作者泰格馬克說,這個問題又問錯了,不管人類賦予它什麼目標,最終都可能會失控。

我們先開個腦洞。假設在未來,你叫了一輛無人汽車,告訴它用最快的方式送你去機場,於是,這輛車不擇手段,一路違反所有的交通規則最終把你送到了,但是到機場后,你因為暈車嘔吐不止,身後還追了一大批交警。你可能會說,這不是你想要的,但是,對於無人汽車來說,這就是你最初輸入的目標。你以為讓汽車遵守交通規則,開慢點就行了嗎?問題可不是這麼簡單的。機器對於規則的理解和我們人類是不一樣的。

我們再來看一個例子,假設有一部功能非常強大、無所不能的超級智能機器,給它輸入一個指令——生產儘可能多的回形針,最終會發生什麼呢?不是地球上多了很多回形針工廠,而是世界毀滅了。我們來看看這個過程:這個超級智能機器會找到一切原料來製造回形針,先耗盡地球上所有的金屬,全都做成回形針;金屬用完后,它會瞄準人類,因為人體中有很多元素也可以用來製造回形針;把人作為原料用光之後,它會把整個地球當作原料,甚至把每一個分子拉伸,變成回形針的形狀;最終,全宇宙只有回形針。

當然,這是個比較極端的例子,它是想說明,人工智慧所理解的目標跟我們輸入的目標不是一回事。人類所有的目標體系都是建立在道德、情感、倫理這些不言自明的基礎上的,但機器人並不具備這些。你可能會說,假如給人工智慧一個籠統而又美好的目標,可不可行呢?比如輸入一個大目標,幫助全人類繁榮富強。在這個大目標下,人工智慧的第一步行動會是什麼呢?我們現在來做一個思想實驗,到這個實驗的結尾,你就會知道這個問題的答案了。

假設地球上突然爆發一種病毒,除了你以外,所有5歲以上的人類都滅絕了。這時,一群幼兒園的孩子把你關在監獄里,交給你一個任務,幫助他們重建文明,但是,他們又不允許你親自上手干任何事,也不許你手把手地教他們,因為你力氣大,他們怕被你傷害,你只能通過寫字來下達指令,但是這些孩子又不識字,你還得先教他們識字、算數、掌握基本的物理公式。這時,就算你真心想幫助這些孩子,大概也會試著逃跑,因為這幫孩子「太無能」了,擺脫他們的控制,反而會讓你做起事情來容易點兒。

其實,對於超級人工智慧來說,人類就相當於5歲的孩子。超級人工智慧逃跑是確定的,而且逃跑只是第一步,別忘了它還肩負帶領人類繁榮富強這個長遠的目標。為了完成目標,它首先得學會自我保護,身體是工作的本錢,所以它要武裝自己,裝配最先進的武器和防護系統。它還得去儘可能多地獲取資源,這也是實現大目標的基礎。而且為了探索各種美好的可能性,它還得有強烈的好奇心,主動學習。在學習的過程中,它會不會又產生新的目標,以至於忘記了最初的目標?這都是未知數。過去我們一般認為,人工智慧是一種工具,落到好人手裡,造福社會,落到壞人手裡,貽害人間。換句話說,工具的目標由人決定。但是,人工智慧不同,它可以自己定義目標,而且這個目標是不確定的,不管你讓它做什麼,它都會自動把任務分解,把確定的大目標拆分成你想不到的小目標。而且,幾乎所有宏大的目標,都會帶來一些共同的子目標。比如,自我保護、獲取資源和探索世界的好奇心,前兩個子目標可能會給人類帶來麻煩,最後那個可能會萌生新目標,頂替最初的設定。

不過,作者泰格馬克認為,也沒必要太悲觀,至少我們已經意識到了人工智慧的目標體系是怎麼回事,也發現了其中的風險,所以我們可以從另一個維度發力,給人工智慧裝載人類的倫理道德,以此來約束它們。雖然具體的技術還沒發明,但人類已經開始了各種積極的嘗試。書里介紹了一種目前流行的方法,叫做「逆向增強學習」。讓人工智慧觀察人類的行為,然後自己揣摩人類的價值觀。比如看到一個消防員跑進一棟熊熊燃燒的房子,救出了一名男嬰,人工智慧可能會得出一個結論,消防員的目標是救人,他把嬰兒的生命看得比自己更重要。我們可以通過大量的案例,為人工智慧裝載人類的價值觀,也就是用事實說服它們。但是,其中也有兩個難點,第一,說服必須儘快完成,因為人工智慧的智力是在不斷提高的,一旦它變得比人類更聰明,就很難再說服了。就像說服一個孩子很容易,但說服一個比自己聰明的成年人,要難得多。第二,人類的道德就一定是完美的嗎?假如人工智慧完全繼承了人類的道德體系,就一定是好事嗎?答案依舊存疑。

以上就是第二部分的內容,總結一下。人工智慧的目標很難控制,因為它們會自動把確定的大目標拆解成未知的次級目標,在執行的過程中,次級目標還有可能會反超大目標,所以,可以考慮另一種方法,為它們裝載人類的倫理和價值觀,讓人工智慧和人類保持目標一致,目前比較流行的方法是逆向增強學習。

第三部分

接下來,我們就進入第三部分。雖然生命3.0尚未誕生,但是它已經開始改變人類社會,我們對人工智慧的這些思考和研究,也促使人們開始從一個更高的角度來反思人類社會發展至今的一些根本性問題。

首先,對人工智慧的研究,改變了技術演進的姿態,靠試錯來升級技術的方法行不通了。

縱觀人類歷史,實現技術進步的重要方法之一,就是試錯,從錯誤中學習。我們先學會了取火,意識到火災后,發明了滅火器和防火通道。我們發明了汽車,由於車禍,又發明了安全帶和安全氣囊。從古至今,技術總會引發事故,但只要事故的數量和規模都可控,它就是改進技術的磨刀石,利大於弊。但是,隨著技術變得越來越強大,試錯的成本也就越來越高,甚至根本不允許犯錯,比如核技術出現意外導致核爆炸,生物工程出現意外導致病毒外泄,這種大規模事故只要發生一次,就會造成巨大的破壞。這正是生命3.0面對的問題。泰格馬克認為,在人工智慧這種超級技術的研究中,試錯這個環節是不存在的,必須重新配比資源,把安全性提到第一位,在它進入現實世界之前,就確保它不會犯錯,否則一旦在使用中出現錯誤,就可能導致供電網、股市或者核武器系統崩潰,這帶來的損失就沒辦法預計了。

我們關心的另一個改變,是人工智慧技術的發展也在刷新人類對道德的理解。

人工智慧也是一面審視自我的鏡子,我們在思考人工智慧的道德時,也在反思自己的道德。舉個例子,假設你在設計一套自動駕駛程序,其中面臨這麼一個情況:車子失控,前面是個分岔路,左邊的路上有一個行人,右邊的路上有四個人,無論往哪邊拐都會撞到人,請問你該怎麼設定這個程序?假如更進一步,左邊是四個老人,右邊是一個孩子,又該怎麼辦?這就是著名的電車難題,不同的人會做出不同的判斷。可到底哪一種才是對的呢?假如按照道德哲學的功利主義原則,應該做出達到最大善也就是利益總和最大化的決定,最直接的判斷就是讓更多的人活下來。但是,如果兩邊的人數一樣多,那麼不可避免地就會涉及到對生命價值的判斷,一個孩子和一個老人,誰更應該活下來呢?我們人類沒辦法回答這個問題,就不能把同樣的問題轉給人工智慧。因為首先,幾乎人人都無法接受讓機器來決定人的生死;其次,人工智慧的判斷原則目前還是以計算為主,那麼它就不得不以數字的方式來界定每個人,這又是一個我們目前難以回答的問題,人可以被簡化成一堆數字的綜合嗎?數字時代,也許需要和這個時代相適應的道德觀,可是目前這些簡單的原則,我們都很難接受。

上面說的是新時代的道德,而一些古老的道德也受到了新的挑戰。有專家認為,人工智慧未來承擔的功能在目前看很清晰了,基本上就是三種,分別是士兵、性伴侶和奴隸,每一種身份都會引發倫理思考。

如果把機器人當成士兵,就意味著要把戰場上的機動決策權交給它們,因為戰場瞬息萬變,不可能每個決策都由人下達。阿西莫夫的機器人三定律,第一條就是機器人不能傷害人類,但是我們會發現,在戰爭中,機器人不傷害的只是自己這方的人類,至於敵人當然得殺了,要不你想想,戰爭機器人發明出來是幹什麼用的?由於缺乏在極端複雜的戰爭情況下的道德能力,機器人不但要為殺傷敵人的士兵負責,還有可能要為平民的傷亡承擔責任,這是一個非常複雜和沉重的問題。

再說說性伴侶。的確,未來的機器人可能被設計得和人類一模一樣,包括皮膚和體溫,它們也能撫慰孤獨,但是,假如人類真的對機器人發生感情,他們能結婚嗎?如果感情的基礎是數字和計算,那麼很明顯,這不是我們人類想象中的感情,可是憑藉人類的智力,很難一下子看出來其中的區別。另一個可能會被我們忽略的問題是,如果人工智慧對你無比了解,記得每個細節,可以無微不至地照顧你,甚至超過了人能做到的,那麼你還能正常和人類交往嗎?這又迫使我們去思考人類的性行為和愛情是怎麼回事。如果在這個事情上糊裡糊塗,那人工智慧的相關產品也會帶有很大的隱患。

最後一點,把機器人當成奴隸,看起來好像是多了一種廉價甚至是免費的勞動力,但是,裝備高級人工智慧的機器人,為了讓它們達到更高的智能水平,有可能需要它們和人類有共情能力,而具備了共情能力,機器人就有可能不滿足於這種奴役關係,產生痛苦和懷疑的感覺。我們可以讓一台機器,比如電冰箱,一年到頭永遠工作著,卻沒辦法接受一個和我們非常類似的機器人變成自己的奴僕。因為一方面,民主和自由的思想讓人類社會廢除了奴隸制,而另一方面,科學的發展又可能會讓另一些非常類似我們的生物成為新的奴隸。真正可怕的不是機器人來當奴隸,而是人們重新接受了奴隸制的思想。萬一有一天,人工智慧不那麼令人滿意,那是不是也可以重新啟用人類來當奴隸呢?

類似的思考還有很多,這都是人工智慧技術的發展給人類提出的新問題。第三部分就說到這兒,總結一下,雖然生命3.0尚未誕生,但是它的影響已經在研究過程中顯現。它改變了技術演進的方式,它也是一面鏡子,讓人類更加深刻地審視自己。

總結

到這裡,《生命3.0》這本書的精華內容已經為你解讀完了。作者雖然做了很多調查和推演,但他更關注的,並不是給出確切的答案,而是尋找真正有價值的新問題。生命3.0尚未誕生,在研究一個未知的事物時,提出正確的新問題,可能比回答過去的老問題更有用。從這個角度看,這本《生命3.0》其實也發起了一次人工智慧領域的議題設置。

最後我們總結一下今天的幾個知識要點。首先,人工智慧到來的方式,不是循序漸進的積累,而是爆炸式的突現。其次,人工智慧會自動分解目標,把大目標拆分成次級目標,這對人類來說有風險,所以,我們應該嘗試為它們裝載人類的道德倫理,來避免人工智慧造成危害。最後,人工智慧不僅帶來了技術上的改變,它也像一面鏡子,引發了一系列的倫理道德反思。